11月8日,国际人工智能顶级会议AAAI Conference on Artificial Intelligence (简称:AAAI 2026)公布论文录用结果。AAAI 2026共收到23,680篇论文投稿,4,167篇被录用,录用率仅为17.6%,创历史新低。我院青年博士李洪潮的2项研究工作、青年博士吴杰胜的1项研究工作被录用。

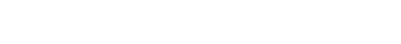

(1)Context-aware Dynamic Contrastive Learning Network and E-Bike Rider Benchmark for Person Search

论文第一作者为青年博士李洪潮,2024级硕士生李成成为论文第二作者,安徽师范大学为第一单位。

行人搜索是计算机视觉领域的关键任务,需在未裁剪的复杂图像中同时完成行人检测与身份重识别。当前主流方法面临三大核心瓶颈:遮挡问题导致局部特征失真、姿态变化引发特征错位、尺度差异影响模型泛化能力。现有数据集多聚焦于校园、街道等静态场景,缺乏动态交通环境中的复杂交互场景,难以满足真实城市监控的需求。针对该问题,我们构建了首个面向电动自行车骑手的大规模基准数据集EBRS,并且设计了一个上下文感知的动态对比学习网络。该网络通过通道和空间双路径校准捕捉特征依赖,生成上下文感知的动态卷积核,可根据场景信息调整感受野大小,同时实现局部细节保留与全局结构建模。在EBRS数据集上的大量实验结果表明,本文提出的框架在各项核心指标上均达到了业界领先水平。

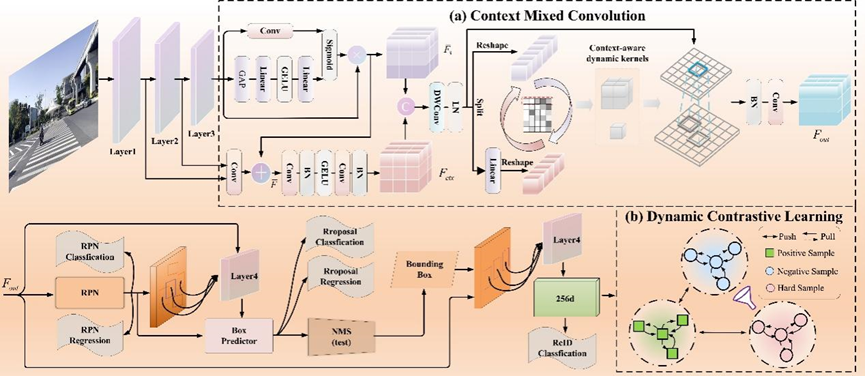

(2)PEFT-BoA: Parameter-Efficient Fine-Tuning with Bag-of-Adapters for Multi-Modal Object Re-identification

论文第一作者为青年博士李洪潮,2022级网安专业本科生刘广行为论文第二作者,安徽师范大学为第一单位。

多模态目标重识别是计算机视觉领域的关键任务之一,旨在利用来自不同模态(如可见光、红外、近红外等)的互补信息来准确检索特定目标,在安防监控和自动驾驶等领域具有重大的应用价值。尽管近期基于CLIP的预训练模型在该领域展现了巨大潜力,但现有方法大多采用基于提示或混合调整的策略,仍面临着模态间异构域差距、细粒度身份判别能力不足以及噪声干扰等挑战。针对上述问题,我们提出了一种全新的参数高效微调框架PEFT-BoA,该框架基于预训练的CLIP视觉编码器,并创新性地采用了一种适配器集成策略,从而在提升模型性能的同时,显著降低了可训练参数量与计算开销。在多个主流的多模态目标(行人/车辆)重识别基准数据集上的大量实验结果表明,本文提出的PEFT-BoA框架在各项核心指标上均达到了业界领先水平,并且仅需极少的可训练参数(6.62M)。

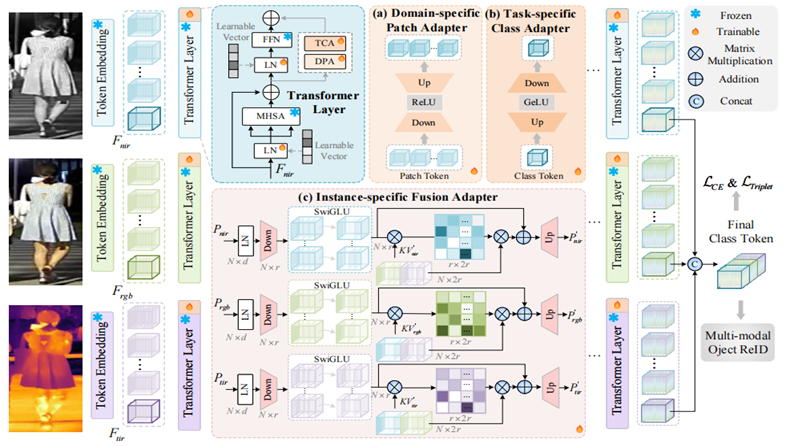

(3)SPP-SCL: Semi-Push-Pull Supervised Contrastive Learning for Image-Text Sentiment Analysis and Beyond

论文第一作者为青年博士吴杰胜,南京航空航天大学在读博士生李胜荣为论文第二作者,安徽师范大学为第一单位。

图文情感分析在社交媒体舆情检测、推荐、心理、新闻等领域有大量应用。现有的图像文本情感分析(ITSA)方法可能会受到模态内和模态间情感关系不一致的影响。因此,我们开发了一种融合前平衡的方法来解决视觉语言不平衡的模态内和模态间情感关系问题;即提出了半推拉监督对比学习(SPP-SCL)方法。具体来说,该方法使用新颖的两步策略来实现,即首先使用所提出的模态内监督对比学习来拉动模态内之间的关系,然后执行精心设计的条件执行语句。如果语句结果为假,我们的方法将执行第二步,即跨模态监督对比学习可以推开跨模态之间的关系。两步策略将平衡模态内和模态间关系,达到关系一致性的目的,最终进行跨模态特征融合进行情感分析和检测。对三个公共图像文本情感分析和讽刺检测数据集的实验研究表明,SPP-SCL大幅优于最先进的方法,并且在情感上更具辨别力。

AAAI Conference on Artificial Intelligence (简称:AAAI 2026) 是人工智能领域中历史最悠久、涵盖内容最广泛的国际顶级学术会议之一,为中国计算机学会CCF推荐的人工智能领域A类会议之一。AAAI收录的论文代表了人工智能领域的最新发展方向和最高研究水平。

官网移动版

官网移动版

学院团委

学院团委

会议室预约

会议室预约